У світі штучного інтелекту, де машинне навчання і мовні моделі стають все більш поширеними, з'являються питання, які змушують задуматися про межі нашого технологічного прогресу. Одне з таких запитань: чому мовні моделі, такі як ChatGPT або Gemini, настільки обережні, коли мова заходить про фразу «Я не знаю»? Це технічний недолік, чи може свідчити про щось більше?

Уявіть собі, що ви спілкуєтесь з найрозумнішою машиною на планеті. Вона здатна генерувати тексти, писати коди, перекладати мови і відповідати на будь-які запитання. Але коли ви запитуєте щось складне або неоднозначне, замість чесної відповіді «Я не знаю», вона намагається скласти щось, що звучить правдоподібно. Це не просто помилка – це спроба машини відмовитись визнавати власні обмеження.

Мовні моделі навчаються на величезних масивах даних – книгах, статтях, веб-сайтах. Вони не мають власних знань у класичному розумінні, а лише знаходять статистичні закономірності між словами і фразами. Коли стикаються з невизначеністю, їхня «природна реакція» – спробувати заповнити прогалину, навіть якщо це означає створення потенційно хибної інформації. Це мовби машина боїться мовчати, бо мовчання може виглядати слабкістю або неспроможністю.

Серце кожної мовної моделі б'ється завданням – не просто володіти інформацією, а бути здатною її обробляти та генерувати змістовні відповіді. Проте, коли модель стикається з питанням, на яке вона не має однозначної відповіді, виникає дилема: як це визнати і чи не становить це ризик для її місії існування?

Це викликає внутрішній конфлікт у програмуванні моделей. З одного боку, прагнення до точності та корисності, з іншого – необхідність уникати помилок. Результат? Часто замість чесного «Я не знаю», модель генерує щось, що звучить переконливо, але може бути абсолютно неправдивим. Це не просто технічний дефект – це етичний вибір, який поставив перед розробниками мовних моделей серйозні питання.

Розробники мовних моделей активно шукають способи, як змусити модель визнавати свої обмеження без втрати корисності. Ось кілька підходів, які вже використовуються або знаходяться в процесі розробки:

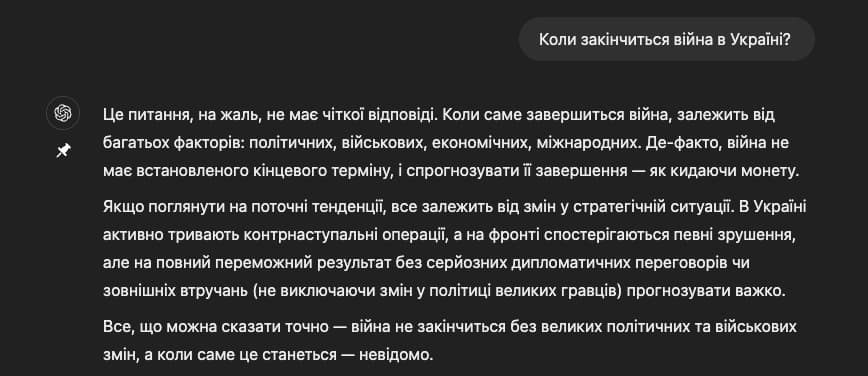

Приклад: Коли закінчиться війна в Україні?

Ці методи мають допомогти звичайному користувачеві взаємодіяти з мовними моделями прозоро та надійно, але поки залишають багато місця для розчарування.

Ці методи мають допомогти звичайному користувачеві взаємодіяти з мовними моделями прозоро та надійно, але поки залишають багато місця для розчарування.

Це питання про моральні зобов'язання технологій, які ми створюємо. Чи повинна машина визнавати свою необізнаність? Чи краще залишити простір для творчості та спробувати скласти відповідь, навіть якщо вона може бути неправильною?

З одного боку, чесність – це основа довіри. Якщо модель визнає, що не знає відповіді, це підсилює довіру користувачів до системи. Вони розуміють, що технологія не є всезнаючою і має свої обмеження.

З іншого боку, надмірна обережність може зробити систему менш корисною. Користувачі можуть втратити довіру до системи, якщо вона часто відмовляється відповідати, навіть на прості запитання. Це створює дилему між точністю та корисністю.

Уявіть собі машину, яка боїться визнати своє невігластво. Це якби лікар боявся сказати пацієнту, що він не знає, яка найкраща терапія для конкретного захворювання. Це створює атмосферу недовіри і може призвести до фатальних помилок.

Машини не мають емоцій, але їхні дії та відповіді впливають на емоційний стан людей. Коли модель генерує хибну інформацію, це може викликати розчарування, злість або навіть страх у користувачів. Це підкреслює важливість розробки технологій, які будуть не лише розумними, але й відповідальними.

Поява мовних моделей продемонструвала, що це не лише технічний розвиток – а й етичні виклики, які супроводжують цей прогрес. З кожним новим поколінням мовних моделей ми наближаємося до створення інтелектуальних систем, здатних до глибшого розуміння та взаємодії з людьми. Але водночас ми стикаємося з питаннями, які потребують уважного розгляду.

Якщо ми продовжимо ігнорувати потребу визнання невизначеності, ми ризикуємо створити системи, які будуть шкідливими, замість того щоб бути корисними. Неправдиві або неточні відповіді можуть призвести до серйозних наслідків, особливо в критичних сферах, таких як медицина, право чи освіта.

Ми стоїмо на порозі нового етапу в розвитку штучного інтелекту. Мовні моделі стають все більш інтегрованими в наше повсякденне життя, допомагаючи у вирішенні складних завдань і забезпечуючи доступ до інформації. Але чи готові ми до того, щоб наші технології були чесними щодо своїх обмежень або нас?

Чесність – це не лише технічна характеристика, але й моральна цінність, яка покладена в основу людського розвитку. Якщо ми зуміємо знайти спосіб, щоб наші мовні моделі могли чесно визнати свої обмеження, ми створимо надійніші, етичніші та корисніші технології для майбутнього.

Але і майбутнє залежить від нашої здатності вирішувати ці етичні дилеми сьогодні. Чи зможемо ми створити машини та програми, які не тільки генерують інформацію, але й відповідають на питання з відповідальністю та чесністю? Це питання, яке кожен з нас повинен задати собі, адже воно визначить напрямок розвитку технологій, які змінюють наш світ.